Использование метода Белсли для прореживания признаков

Материал из MachineLearning.

Содержание |

Постановка задачи

Задана выборка признаков и зависимой переменной. Рассматривается линейная регрессионная модель вида:

Предполагается, что вектор регрессионных невязок имеет нулевое математическое ожидание и дисперсию

.

С помощью метода Белсли требуется выявить мультиколлинеарность признаков и устранить её.

Описание алгоритма

Методика Belsley, Kuh, и Welsch (BKW)

Согласно Белсли для выделения мультиколлинеарных зависимостей с матрицей производят сингулярное разложение

- диагональная с неотрицательными элементами

называющимися сингулярными числами

.

Далее вычисляются два параметра, по которым будет будет определяться зависимость

1) Индексы обусловленности это:

,

.

Наибольший из индексов обусловленности -- это число обусловленности матрицы . Большое значение

указывает на зависимость близкую к линейной между признаками и чем больше

тем сильнее зависимость.

2) Дисперсионные доли.

Дисперсионные доли находятся следующим образом: из сингулярного разложения ковариационная матрица метода наименьших квадратов может быть записана как:

Таким образом дисперсия -го регрессионного коэффициента

это

-й диагональный элемент

где.

Определим -е дисперсионное соотношение как долю дисперсии

-го регрессионного коэффициента связанная с

-м компонентом его разложения. Доля считается как:

,

,

Дисперсионное соотношение:

,

Наличие мультиколлинеарности определяется по таблице.

| Индекс обусловленности | ||||

|---|---|---|---|---|

| | | | ... | |

| | | | ... | |

| | | | | |

| | | | ... | |

Большие величины означают, чтовозможно есть зависимость между признаками.

Большие значения в соответствующих строках относятся к признакам, между которыми эта зависимость существует.

Вычислительный эксперимент

Пример 1

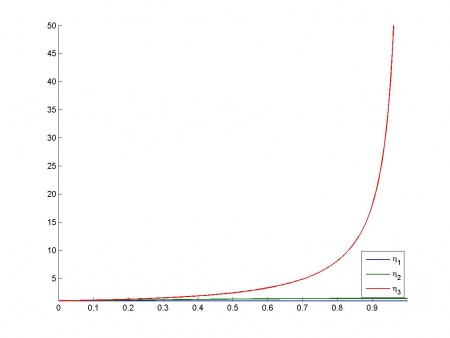

В эксперименте используются модельные данные, для которых вычисляется матрица Belsley в зависимоти от параметра определяющего степень коллинеарности между признаками.

Используются два ортогональных признака ,

и третий признак

зависящий от параметра

. При

все признаки ортогональны, при увеличении

зависимый признак

приближается к

, вплоть до полной коллинеарности при

.

Зависимость индексов обусловленности

от

:

Пример 2

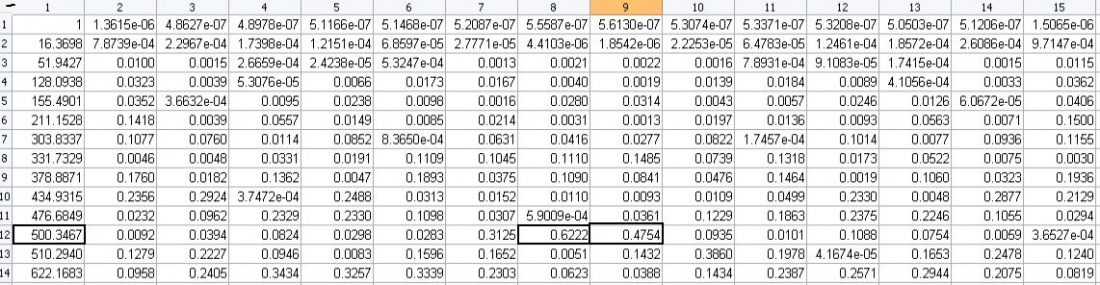

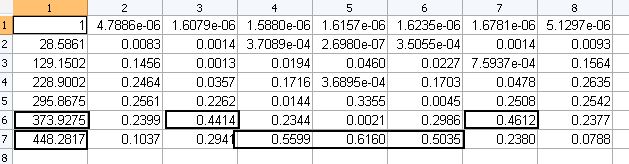

Используются реальные данные по продажам товаров.

Для двух различных матриц был проведён эксперимент по вычислению таблицы BKW </br></br>

1)

</br>

Из таблицы видно, что наблюдается связь между признаками 8 и 9</br>

2)

</br>

Самому большому индексу обусловленности соответствует связь между 4,5 и 6-ым признаками, также наблюдается связь между признаками 3 и 7.

Исходный код

Смотри также

- Мультиколлинеарность

- Метод наименьших квадратов

- Линейная регрессия (пример)

- Анализ мультиколлинеарности (пример)

- Сингулярное разложение

- Метод Белсли

Литература

- В.В. Стрижов Методы выбора регрессионных моделей

- Gianfranco Galmacci, Collinearity Detection in Linear Regression. Computational Economics 9:215-227, 1996.

| | Данная статья была создана в рамках учебного задания.

См. также методические указания по использованию Ресурса MachineLearning.ru в учебном процессе. |